Как зрительно-языковые модели меняют мир: Полное руководство по VLM

Зрительно-языковые модели (Vision-Language Models, VLM) — это прорыв в искусственном интеллекте, который объединяет возможности обработки изображений и текста. Они позволяют машинам не только видеть, но и понимать мир так, как это делает человек. В этой статье мы разберем, что такое VLM, как они работают, где применяются и какие перспективы открывают. С дружелюбным и понятным подходом погрузимся в мир мультимодальных технологий, чтобы раскрыть их потенциал!

Что такое зрительно-языковые модели

Зрительно-языковые модели — это системы ИИ, которые одновременно обрабатывают визуальные данные (изображения, видео) и текст. Они находятся на стыке компьютерного зрения и обработки естественного языка (NLP), позволяя машинам анализировать изображения, генерировать текстовые описания или отвечать на вопросы о визуальном контенте. Например, VLM может описать фото заката как «Оранжевый закат над морем с легкими облаками» или ответить на вопрос: «Что на картинке?»

Эти модели относятся к мультимодальным, так как работают с несколькими типами данных. Если VLM создает текст, изображения или ответы на основе входных данных, она классифицируется как генеративный ИИ. Их универсальность делает их незаменимыми в задачах от создания подписей до анализа сложных сцен.

NLP (Natural Language Processing) — обработка естественного языка, область ИИ, которая анализирует и генерирует человеческий язык.

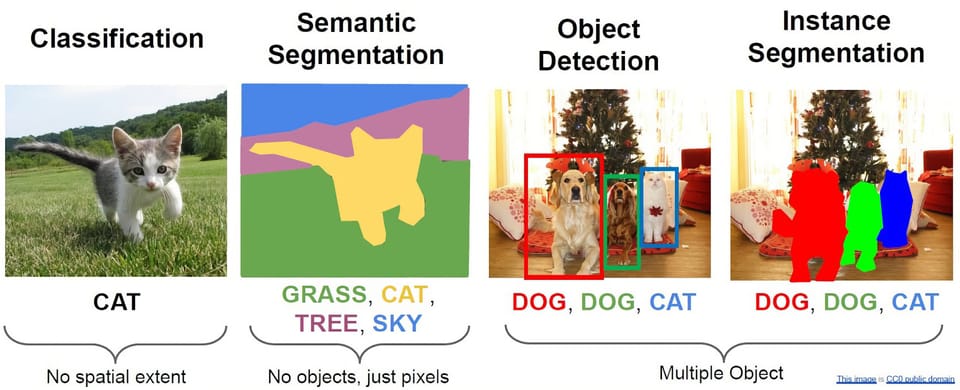

Типы зрительно-языковых моделей

VLM можно разделить на несколько категорий в зависимости от их функций. Рассмотрим основные типы.

Модели «изображение в текст»

Эти модели преобразуют визуальные данные в текст. Ключевые примеры:

- Генерация подписей (Image Captioning)

Модель создает текстовое описание изображения, например: «Кот сидит на красном диване». Это полезно для социальных сетей, доступности контента и автоматической разметки данных. - Визуальный вопросно-ответный диалог (VQA)

Модель отвечает на вопросы по содержимому изображения, например: «Что держит человек?» — «Книга». Такие системы применяются в образовательных платформах и для помощи людям с нарушениями зрения.

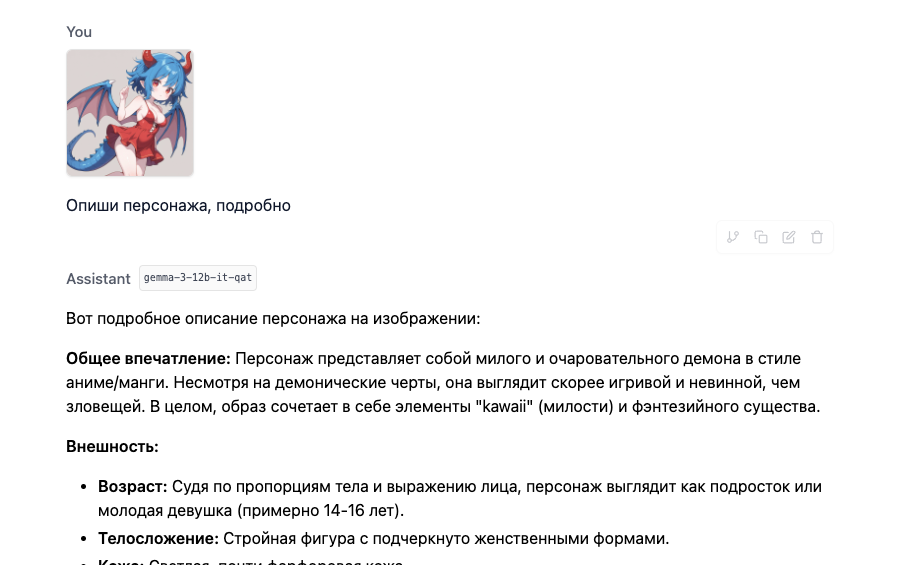

Полный ответ нейросети

Вот подробное описание персонажа на изображении:

Общее впечатление: Персонаж представляет собой милого и очаровательного демона в стиле аниме/манги. Несмотря на демонические черты, она выглядит скорее игривой и невинной, чем зловещей. В целом, образ сочетает в себе элементы "kawaii" (милости) и фэнтезийного существа.

Внешность:

- Возраст: Судя по пропорциям тела и выражению лица, персонаж выглядит как подросток или молодая девушка (примерно 14-16 лет).

- Телосложение: Стройная фигура с подчеркнуто женственными формами.

- Кожа: Светлая, почти фарфоровая кожа.

- Волосы: Ярко-голубые, короткие и вьющиеся волосы, обрамляющие лицо. Прическа выглядит слегка небрежной, но стильной.

- Глаза: Большие, круглые глаза с ярко-красным цветом радужки. Выражение глаз наивное и немного застенчивое, с легким намеком на игривость. Зрачки большие и темные, что усиливает впечатление больших глаз.

- Рога: Два небольших, изогнутых рога цвета слоновой кости или светло-коричневого цвета, растущие из волос. Они не выглядят угрожающе, а скорее добавляют персонажу милоты.

- Хвост: Длинный, синий хвост с шипами вдоль всей длины. Хвост слегка изогнут и кажется гибким.

- Крылья: Пара небольших крыльев, напоминающих крылья летучей мыши или дракона. Они темно-синие с красными прожилками. Крылья кажутся не очень сильными, что добавляет персонажу беззащитности.

- Уши: Острые эльфийские уши, слегка выступающие из волос.

Одежда:

- Персонаж одета в короткое красное платье с корсетной завязкой на груди. Платье выглядит легким и воздушным, подчеркивая фигуру.

- Платье имеет оборки по низу, что добавляет ему игривости.

Поза и выражение лица:

- Персонаж стоит в слегка приподнятой позе, одна нога немного согнута вперед.

- Она смотрит на зрителя с легкой улыбкой и застенчивым выражением лица. Одна рука поднята вверх, как будто она что-то предлагает или показывает.

Общая атмосфера: Персонаж создает впечатление милого, игривого и немного невинного демона. Она кажется дружелюбной и открытой для общения. Ее образ сочетает в себе элементы фэнтези, аниме/манги и "kawaii" стиля.

Модели «текст в изображение»

Эти модели работают в обратном направлении, создавая визуальный контент на основе текста. Примеры:

- Генерация изображений (Text-to-Image Generation)

Модель, такая как DALL·E, создает картинки по описаниям, например, «Фантастический город в облаках». Это востребовано в дизайне, рекламе и креативных индустриях. - Редактирование изображений по тексту

Модель может изменить картинку по инструкции, например, «Сделай фон закатным». Это упрощает работу дизайнеров и фотографов.

Модели кросс-модального поиска

Эти модели связывают текст и изображения для поиска данных. Примеры:

- Поиск изображений по тексту

Пользователь вводит запрос «Собака на пляже», и модель находит подходящие картинки. Это улучшает поисковые системы. - Поиск текста по изображению

Загрузив фото, пользователь получает связанные тексты, например, описание объекта или статью. Это полезно для анализа контента.

Как работают зрительно-языковые модели

Работа VLM основана на сложной архитектуре, включающей обработку данных, их объединение и генерацию результата. Разберем процесс поэтапно.

Входные данные: изображение и текст

VLM обрабатывают два типа данных:

- Визуальные данные

Изображения анализируются с помощью сверточных нейронных сетей (CNN), таких как ResNet, или визуальных трансформеров (ViT). Они преобразуют картинку в эмбеддинги, которые содержат информацию о формах, объектах и текстурах. - Текстовые данные

Текст обрабатывается трансформерными моделями, такими как BERT или GPT. Слова преобразуются в эмбеддинги, отражающие их смысл и контекст.

CNN (Convolutional Neural Network) — сверточная нейронная сеть, используемая для анализа изображений.

ViT (Vision Transformer) — трансформерная модель, которая разбивает изображение на патчи и обрабатывает их как последовательность.

Эмбеддинги — числовые векторы, представляющие данные в формате, понятном для ИИ.

Извлечение и представление признаков

Оба типа данных преобразуются в единое пространство:

- Визуальные признаки: Векторы, описывающие элементы изображения, такие как объекты или фон.

- Текстовые признаки: Векторы, содержащие семантику слов и предложений.

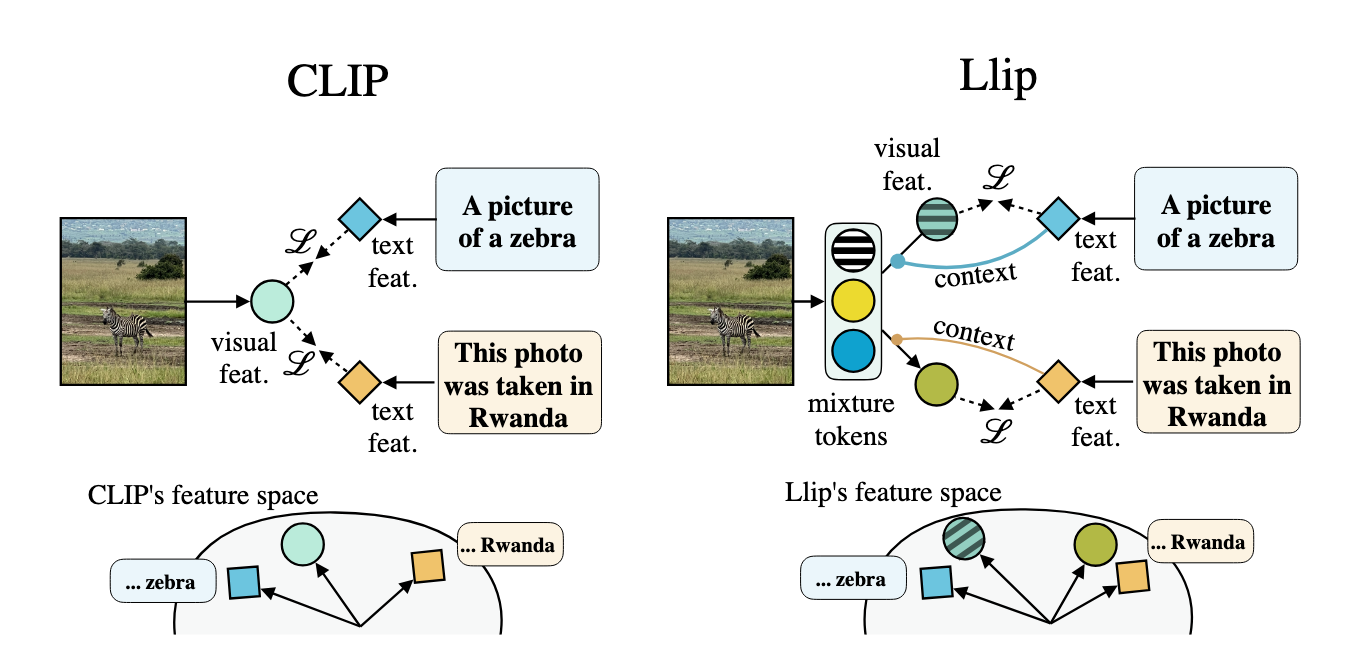

Кросс-модальное выравнивание

Модель выравнивает визуальные и текстовые признаки в общем пространстве. Например, слово «кошка» связывается с изображением кошки. Это достигается с помощью:

- Контрастного обучения

Модель минимизирует расстояние между связанными парами текст-изображение и увеличивает его для несвязанных. Это помогает модели CLIP точно сопоставлять данные. - Механизмов внимания

Кросс-модальное внимание позволяет фокусироваться на релевантных частях текста и изображения, улучшая понимание.

Слои объединения

После выравнивания признаки объединяются в единое представление. Основные подходы:

- Раннее объединение

Визуальные и текстовые данные комбинируются на ранних этапах обработки. - Позднее объединение

Признаки обрабатываются отдельно, а затем объединяются в конце. - Кросс-внимательное объединение

Модель одновременно учитывает обе модальности, что улучшает точность. Модель VisualGPT, например, использует эту технику с функцией SRAU, предотвращающей исчезновение градиентов.

SRAU (Self-Restoring Activation Unit) — механизм, стабилизирующий обучение моделей ИИ.

Исчезновение градиентов — проблема, при которой модель теряет информацию из-за малых обновлений параметров.

Цели обучения

VLM обучаются на больших наборах данных, таких как COCO или Flickr30k, с задачами:

- Сопоставление изображение-текст (ITM): Модель учится связывать картинки с текстом.

- Маскированное языковое моделирование (MLM): Предсказание пропущенных слов с учетом изображения.

- Маскированное моделирование изображения (MIM): Восстановление пропущенных фрагментов картинки.

- Генерация подписей: Создание текстовых описаний для изображений.

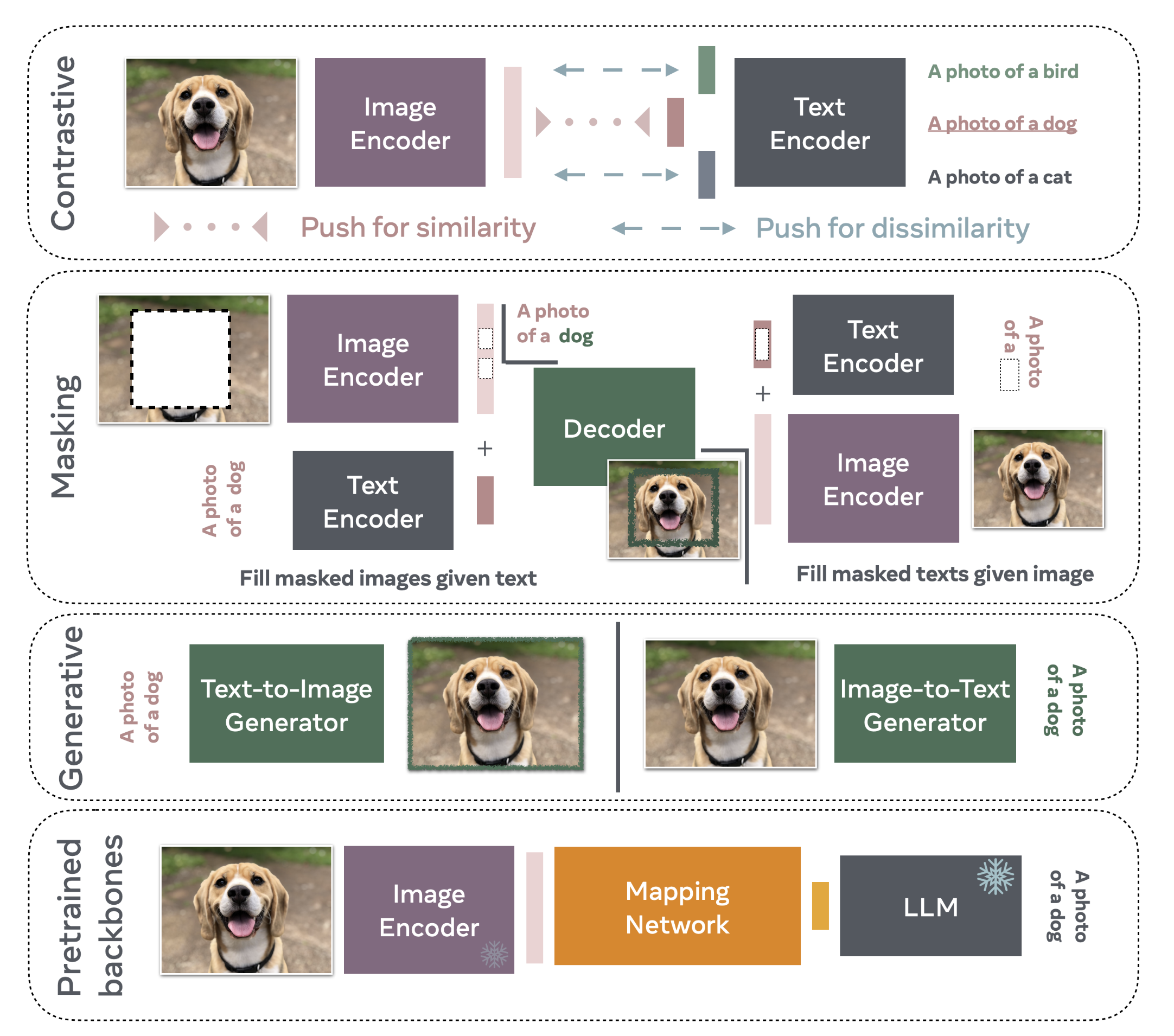

Техники, используемые в VLM

VLM опираются на передовые методы, обеспечивающие их эффективность.

Трансформеры

Трансформеры — основа большинства VLM. Они отлично обрабатывают последовательные данные, будь то текст или патчи изображения, как в модели ViLT.

PrefixLM

Техника PrefixLM учит модель предсказывать следующие слова на основе текста и изображения. Модель SimVLM использует упрощенную трансформерную архитектуру, но превосходит многие аналоги благодаря этой технике.

Предобучение и дообучение

VLM сначала обучаются на больших наборах данных, а затем дообучаются для конкретных задач, что повышает их точность.

Применение зрительно-языковых моделей

VLM трансформируют множество отраслей. Рассмотрим ключевые области.

Электронная коммерция

VLM автоматизируют создание описаний товаров. Например, модель BLIP-2 генерирует тексты вроде «Хлопковая рубашка с длинным рукавом», что улучшает SEO и помогает клиентам находить продукты. Это экономит время и повышает продажи.

Доступность интернета

VLM создают подписи к изображениям, делая контент доступным для людей с нарушениями зрения. Например, модель описывает фото как «Кошка на диване», что помогает скринридерам. Функция Google «Get Image Descriptions» использует VLM, а техники, такие как подсказка по цепочке мыслей, улучшают качество описаний.

Образование

VLM поддерживают образовательные платформы, отвечая на вопросы по изображениям или создавая учебные материалы. Например, студент может загрузить диаграмму и спросить: «Что это?»

Здравоохранение

VLM анализируют медицинские снимки, помогая врачам выявлять аномалии и ускоряя диагностику.

Креативные индустрии

VLM генерируют контент для рекламы, игр и виртуальной реальности, создавая изображения или интерактивные истории.

Примеры:

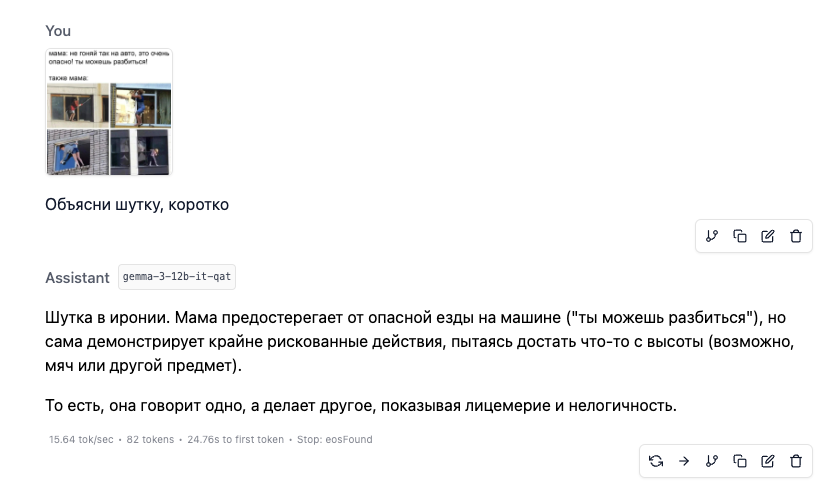

Объяснения мема

Подсчёт количества людей

Выявление нарушений

Ответ ChatGPT

Шаг 1: Анализируем каждый рисунок отдельно.

- Рисунок 1:

Двое детей бегут через пешеходный переход, не убедившись в безопасности — автомобиль очень близко. Это опасно. Пешеходы должны уступать автомобилям, если переход не регулируемый и машина близко. - Рисунок 2:

Пешеходы идут по "зебре", а машина стоит, пропуская их, как положено. Нарушения нет. - Рисунок 3:

Мальчик выбегает из-за припаркованного автомобиля, не убедившись в обстановке. Это грубое нарушение: выскакивать на дорогу из-за препятствия запрещено, потому что водитель не видит пешехода заранее.

Шаг 2: Формулируем итоговый вывод.

Нарушения ПДД показаны на рисунках 1 и 3.

Но если вопрос подразумевает выбрать один рисунок, где нарушение наиболее очевидное и опасное — это рисунок 3.

✅ Итоговый ответ:

Нарушение ПДД показано на рисунке 3.

Преимущества и ограничения VLM

Преимущества

- Улучшение взаимодействия

VLM делают чат-боты и помощников более универсальными, понимающими текст и изображения. - Аналитика и диагностика

От медицины до автономных систем, VLM расширяют возможности ИИ. - Креативность

Генерация контента открывает новые горизонты для дизайна и развлечений.

Ограничения

- Высокие затраты

Обучение VLM требует мощных серверов, что дорого. - Предвзятость данных

Если данные содержат ошибки или стереотипы, модель может выдавать некорректные результаты. - Ограниченное понимание контекста

VLM иногда упрощают сложные сцены, теряя общий смысл.

Будущее зрительно-языковых моделей

VLM продолжают развиваться, становясь точнее и доступнее. В будущем они могут стать основой для дополненной реальности, улучшенных поисковых систем и умных помощников. Однако важно минимизировать предвзятость и обеспечивать этичное использование. С ростом вычислительных мощностей VLM будут менять нашу жизнь, делая технологии ближе к людям.

Заключение

Зрительно-языковые модели — это мост между визуальным и текстовым мирами. Они открывают невероятные возможности для бизнеса, творчества и социальной пользы. От автоматических описаний товаров до помощи людям с ограниченными возможностями — VLM уже здесь, чтобы изменить будущее. Следите за их развитием, ведь это только начало!

Где можно попробовать в России?

- https://alice.yandex.ru Яндекс недавно представил поддержку анализа изображений

- https://giga.chat Гигачат от сбербанка умеет анализировать изображения

- https://chat.qwen.ai Китайсая модель Qwen2.5-VL-32B-Instruct умеет работать с изображениями, а модель QVQ-Max не только работает с изображениями и текстом, но и способна рассуждать

Комментарии ()