Вышел DeepSeek V3.2 из китайского open‑source лагеря

Здравствуйте! Давайте разложим по полочкам, что случилось с релизом DeepSeek V3.2 и почему об этом сейчас говорит почти весь технологический мир. В статье разберем архитектуру (простыми словами), реальные цифры производительности и цен, сравним с лидерами, поймем, зачем нужны две версии (V3.2 и Speciale), где это применимо на практике и как начать работать уже сегодня. А еще — честно обсудим ограничения и дорожную карту.

Краткое резюме: что такое DeepSeek V3.2 и почему это важно

- DeepSeek V3.2 — новый этап от китайского open‑source стартапа DeepSeek: две модели (V3.2 и V3.2‑Speciale), обе под MIT‑лицензией.

- Ключевая техническая новизна — DeepSeek Sparse Attention (DSA), которая снижает «стоимость внимания» к длинным текстам: память и скорость растут, а цена падает примерно вдвое при близком качестве.

- V3.2 заявляет производительность уровня GPT‑5 при заметно более низкой цене API. Speciale показывает сильные результаты на сложных задачах (олимпиады, программирование), но потребляет больше токенов и пока доступна временно.

- Практический вывод: open‑source LLM стали ближе к «фронтирному» качеству и доступнее для компаний, разработчиков и исследователей.

Технический обзор: что внутри и как это работает

Архитектура и контекст

V3.2 — промежуточная ступень к архитектуре следующего поколения, основанная на V3.1‑Terminus. Главная фишка — внедрение DeepSeek Sparse Attention (DSA): вместо того чтобы каждый токен обращал внимание на все остальные (O(L²)), модель отбирает только самые релевантные (примерно топ‑k), что снижает сложность к практически линейной O(Lk).

Простыми словами: обычный механизм внимания — как попытка слушать весь шумный зал и улавливать смысл. DSA — как умение слышать конкретный диалог, игнорируя лишнее.

Параметры и эффективность

- 671 млрд параметров, но активируется только ~37 млрд токенов для каждого запроса (Mixture‑of‑Experts + разреженное внимание).

- Поддержка контекста до 128 тыс. токенов.

- Внедрены улучшенные CUDA‑ядра и оптимизации для платформ H200/AMD MI; официальная поддержка фреймворков SGLang и vLLM для sparse‑ядров.

Как это звучит на практике

Представьте: вы ведете научную статью, где нужны ссылки на прошлые главы и таблицы. Обычная модель либо «забывает» детали, либо вынуждена тратить много ресурсов, чтобы все удерживать. V3.2 экономит внимание на «шуме» и лучше фокусируется на нужном фрагменте, при этом сохраняя качество.

Показатели: скорость, память, стоимость, качество

- Скорость: рост в 2–3 раза для задач с длинными контекстами.

- Память: снижение на 30–40%.

- Стоимость API: падение цены ~на 50% по сравнению с V3.1-Terminus.

- Пример: входящие токены ~$1.28 за млн (с кэшем ~$1.028), исходящие ~$1.42 за млн; у V3.1-Terminus было ~$1.56 и ~$1.68 соответственно.

- Качество: близкое к предыдущей версии по общим задачам, но на тяжелом рассуждении Speciale заметно выигрывает.

Вывод: для компаний и команд, которые активно работают с длинными документами или кодом, экономия может быть значительной — при сохранении сопоставимого качества.

Две модели: как выбрать под задачу

V3.2: универсальная рабочая лошадка

- Баланс скорости и качества рассуждений.

- Поддержка режимов быстрого ответа и пошагового рассуждения.

- Подходит для ежедневной работы: резюмирование, QA, анализ кода, агентные задачи.

Примеры применения:

- Юридическая проверка контрактов.

- Генерация документации для кодовой базы.

- Быстрые ответы с проверкой фактов.

- Навигация и сбор информации в веб‑инструментах.

V3.2‑Speciale: монстр для сложных задач

- Ориентирована на тяжелые цепочки рассуждений, планирование, длинные задачи.

- Показала высокие результаты на олимпиадах и бенчмарках для программирования (IMO/CMO, AIME 96.0%).

- Временная доступность через отдельный API; потребляет больше токенов.

Примеры применения:

- Автоматическое доказательство теорем.

- Сложные многошаговые алгоритмы и рефакторинг.

- Продвинутое обучение в STEM, анализ нестандартных задач.

- Стратегическое планирование с множеством зависимостей.

Совет: если нужна стабильная ежедневная работа — выбирайте V3.2; если решаете «чистые» олимпиадные задачи и не боитесь лишних токенов — Speciale.

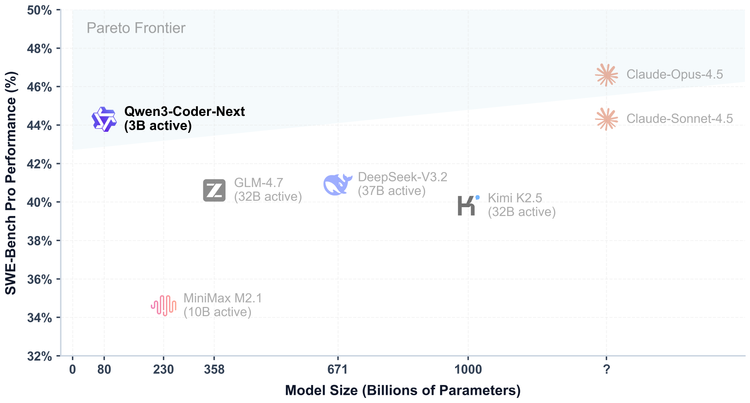

Бенчмарки и сравнение с лидерами

- Математика и логика: AIME 2025 — Speciale 96.0% против GPT‑5 High 94.6%.

- Программирование:

- Codeforces (режим рассуждений): V3.2 — ~2121; Speciale — ~2708; Gemini‑3.0‑Pro — ~2537.

- SWE‑Bench Verified: V3.2 — ~67.8%; Speciale — ~73.1%.

- Агентные задачи:

- BrowseComp — ~40.1%; SimpleQA — ~97.1%; Terminal‑bench — ~37.7%.

- Где Speciale пока отстает: HLE (Humanity’s Last Exam) — Gemini 3.0 Pro ~37.7% против ~30.6% у Speciale.

Практический смысл: в чистом рассуждении Speciale способна состязаться с передовыми моделями, но в задачах экстремальной сложности с мультимодальным контекстом лидерство остается за Gemini.

Где это применимо: реальные сценарии

- Длинные документы: анализ, резюмирование, юридические проверки.

- Разработка: исправление багов, генерация документации, навигация по кодовой базе.

- Агенты: веб‑поиск, факт‑чекинг, автоматизация рабочих процессов.

- Образование и наука: помощь в решении сложных STEM‑задач, доказательства, гипотезы.

Пример: если вы ведете международный контракт с вложениями и ссылками на разделы, V3.2 поможет пройти по ключевым темам, не «теряя конец» длинного документа.

Open‑source и лицензия MIT: что это значит для вас

- MIT‑лицензия: свободно использовать, изучать, модифицировать и распространять.

- Веса доступны на Hugging Face и GitHub, демо‑коды, обновленные CUDA‑ядра, поддержка разных платформ.

- Оптимизация через SGLang и vLLM с sparse‑ядрами.

- Философия: «open‑weight» — веса и код открыты, но тренировочные данные обычно не публикуются полностью. Это стандарт рынка: ни одна фронтирная LLM не публикует полный набор обучающих данных.

Смысл: вы получаете высокий уровень прозрачности и свободу, недоступный в закрытых системах. Для бизнеса — это контроль над расходами и возможностью кастомизации.

Реакция рынка: давление на конкурентов

- Понижение цен API на ~50% при сохранении качества создает ощутимое давление на провайдеров.

- Обсуждения в сообществе подчеркивают: open‑source модели становятся сильнее, а закрытые лидеры должны снижать цены или улучшать продукты.

- Геополитика и инновации: в области LLM значительная доля серьезных исследований выходит из Китая; в open‑weight направлении Китай доминирует.

Практический эффект: у компаний появляется реальная альтернатива, что стимулирует рынок к здоровому развитию.

Ограничения и будущие направления

- Токенная эффективность: Speciale расходует больше токенов на сложные задачи.

- Лимит контекста: 128K токенов — достаточно для многих сценариев, но некоторым агентным задачам нужно больше.

- Избыточная самопроверка: длинные траектории рассуждения замедляют работу и увеличивают стоимость.

- Экспериментальный статус: часть релизов — временные, стабильные продакшн‑версии могут прийти позже.

Планы:

- Расширение контекстного окна.

- Оптимизация рассуждений и токенной эффективности.

- Мультимодальность: работа с изображениями, видео, аудио.

Как начать работать с DeepSeek V3.2: пошагово

Через API

- Зарегистрируйтесь на платформе DeepSeek и получите API‑ключ.

- Используйте стандартные SDK (Python, Node.js, cURL); API совместим с форматом OpenAI.

- Для режима «мышления» укажите нужный путь/параметр у провайдера (в общих чертах — специальный режим модели с пошаговым рассуждением).

- Для Speciale может быть временный endpoint с ограничением по дате доступа — проверяйте актуальную документацию провайдера.

Локальное развёртывание

- Скачайте веса на Hugging Face или GitHub.

- Выберите формат тензоров (например, BF16/FP8) под ваше «железо».

- Разверните через SGLang или vLLM с поддержкой sparse‑ядров.

- Для тяжелых задач используйте платформы класса H200/AMD MI, если доступны.

Веб и мобильные приложения

- Для быстрых экспериментов можно использовать сайт DeepSeek или мобильное приложение, если они доступны в вашем регионе.

- Часть задач доступна через универсальные интерфейсы (например, платформами, агрегирующими множество моделей), но внимательно читайте условия и региональную доступность.

Полезный совет: всегда сравнивайте стоимость и качество на ваших реальных задачах — бенчмарки дают ориентир, но «рабочая» точность определяется вашими данными.

Ценообразование и экономика: как посчитать выгоду

- Пример из расчетов: если ваш бизнес обрабатывает 100 млн входящих токенов и 50 млн исходящих, экономия на API может составить до ~30–50% по сравнению с V3.1‑Terminus.

- Для тяжелых задач Speciale итоговая стоимость может быть выше из‑за увеличенного потребления токенов. Планируйте бюджет и включайте кэширование, где возможно.

Рекомендации по выбору модели и сценариев

- Выбирайте V3.2 для повседневных задач с длинным контекстом, где важны скорость и стоимость.

- Используйте Speciale для «чистого» сложного рассуждения, олимпиадных задач, многошаговых планов — понимая, что токенов потребуется больше.

- Проводите пилоты: сравните качество и стоимость на ваших наборах данных, а не только по бенчмаркам.

- Для продакшн‑задач лучше дождаться стабильной версии или держать проверенный «базовый» вариант на случай пиковых нагрузок.

Итоги: что меняет V3.2

- Open‑source модели выходят на конкурентный уровень фронтира, но остаются доступными и прозрачными.

- Снижение цен и повышение эффективности внимания (DSA) делают длинные сценарии реально выгоднее.

- Для разработчиков — меньше бюрократии, больше свободы; для компаний — снижение TCO; для исследователей — возможность проверить и улучшать.

Это не просто новый «релиз». Это сигнал рынку: будущее ИИ может быть открытым, эффективным и доступным уже сейчас. И если вы ищете способ улучшить процессы без увеличения бюджета — V3.2 может стать правильным выбором.

Хотите попробовать прямо сейчас — начинайте с API, проверяйте на своих задачах, а при необходимости разворачивайте локально: код и веса открыты, а экономия может быть ощутимой уже в первые недели. Удачных экспериментов!

Комментарии ()